Im vergangenen September erregte ein Beitrag im n8n-Community-Forum unsere Aufmerksamkeit. Ein Entwickler aus Deutschland erklärte, dass er KI-gestützte WhatsApp-Workflows für seine Kundinnen und Kunden erstelle, dabei jedoch an Grenzen stoße. Er benötigte eine DSGVO-konforme KI-Inferenz – und der einzige Weg, dies in n8n umzusetzen, bestand darin, manuell für jeden einzelnen IONOS Cloud API-Aufruf eigene HTTP-Request-Nodes zu programmieren. Seine Frage: Ist eine native Integration geplant?

Dieser Forenbeitrag war keine isolierte Anfrage. Wir haben Ähnliches von Partnerunternehmen, Kundinnen und Kunden aus ganz Europa gehört. Für alle, die es noch nicht kennen: n8n ist eine Open-Source-Plattform für Workflow-Automatisierung, vergleichbar mit Zapier. n8n lässt sich aber selbst hosten und vollständig erweitern. Nutzerinnen und Nutzer entscheiden sich aufgrund der Flexibilität und Transparenz für n8n und für IONOS Cloud wegen der Souveränitätsgarantie. Die Verbindung beider Welten erforderte jedoch das mühsame Zusammenfügen roher API-Aufrufe – eine Arbeit, die den eigentlichen Zweck einer visuellen Automatisierungsplattform ad absurdum führt.

Unsere Antwort: Eine native Integration mit fünf Nodes und über 200 Operationen auf Open-Source-Basis. Von der Server-Bereitstellung bis zur souveränen KI-Inferenz steuern Sie nun alles direkt im visuellen Editor von n8n.

Was wir veröffentlicht haben

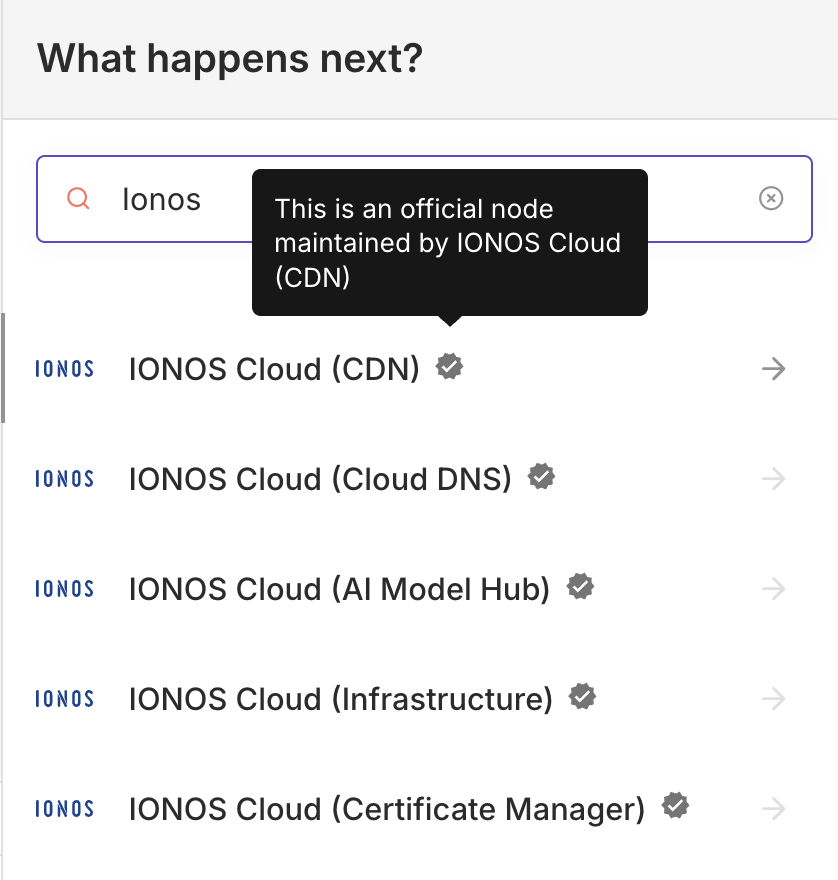

Unser n8n-verifiziertes Community-Node-Paket – @ionos-cloud/n8n-nodes-ionos-cloud – ist seit Januar auf npm verfügbar. Es bietet fünf spezialisierte Nodes, über 30 Ressourcen und 223 Operationen – alles vollständig Open Source.

Die Details im Überblick:

Die Infrastructure-Node ist mit über 150 Operationen das Rückgrat des Pakets. Sie ermöglicht es, komplette Rechenzentren einzurichten, Server bereitzustellen, Volumes einzubinden sowie NICs und Firewall-Regeln zu verwalten. Auch komplexere Setups wie Kubernetes-Cluster inklusive Node-Pools, Network und Application Load Balancer, NAT-Gateways oder Security-Groups lassen sich damit orchestrieren. Der gesamte Stack ist abgedeckt. Besonders smart: Über die integrierte Vertrags-Ressource können Ressourcenlimits abgefragt werden. So lassen sich Workflows erstellen, die vor einer Bereitstellung automatisch die Quoten prüfen und bei Engpässen warnen. Damit lässt sich praktisch jede Funktion des Data Center Designers direkt über n8n automatisieren.

Die Cloud DNS-Node unterstützt fast 30 Operationen für primäre und sekundäre Zonen (mit voller AXFR-Transfer-Unterstützung), inklusive aller wichtigen DNS-Eintragstypen, DNSSEC-Konfiguration, Zonen-Import/Export im BIND-Format und Reverse-DNS. Die Certificate Manager-Node automatisiert den Lebenszyklus von SSL-Zertifikaten, einschließlich der automatischen Verlängerung über ACME-Anbieter wie Let’s Encrypt. Abgerundet wird das Paket durch die CDN-Node, mit der Distributionen samt benutzerdefinierter Routing-Regeln und Geo-Restrictions im Handumdrehen eingerichtet werden können.

Doch das eigentliche Highlight, auf das ich nun im Detail eingehen möchte, verändert die Spielregeln für KI-Workflows grundlegend:

Die AI Model Hub-Node: Souveräne KI trifft auf Workflow-Automatisierung

Das entscheidende Differenzierungsmerkmal zu herkömmlichen Cloud-Integrationen ist die IONOS Cloud AI Model Hub node.

Hintergrund: Der IONOS AI Model Hub ist unsere Managed-AI-Inferenzplattform, die vollständig in deutschen Rechenzentren betrieben wird. Sie bietet eine kuratierte Auswahl führender Open-Source-Modelle, darunter LLMs wie Metas Llama für die Textgenerierung, spezialisierte Modelle von Mistral und europäische Initiativen wie openGPT-x. Auch Text-zu-Bild-Modelle für die Erstellung visueller Inhalte gehören zum Portfolio, das wir kontinuierlich erweitern. Keine Daten verlassen Deutschland. Es werden keine Daten für das Modelltraining verwendet. Der gesamte Service wird von einem europäischen Unternehmen auf europäischem Boden unter europäischer Gerichtsbarkeit betrieben und ist somit vor Zugriffen von außerhalb Europas geschützt.

Warum ist das wichtig? Weil sich die regulatorische Landschaft verändert. Die EU-KI-Verordnung (EU AI Act) führt neue Verpflichtungen zur Transparenz und zum Risikomanagement für KI-Systeme ein. Die Durchsetzung der DSGVO wird immer strenger. Für viele Unternehmen ist der einfachste Weg, diese Anforderungen zu erfüllen, sicherzustellen, dass die Daten von vornherein den europäischen Rechtsraum nicht verlassen. Unsere n8n-Node macht diese strategische Entscheidung so einfach wie die Auswahl aus einem Drop-down-Menü.

Die Kundendaten fließen in ein deutsches Rechenzentrum, werden von einem inspizierbaren Open-Source-Modell verarbeitet und kommen zurück – ohne jemals die europäische Gerichtsbarkeit zu verlassen. Das ist kein Marketingversprechen. Das ist Souveränität per Klick.

Was die Node konkret leistet

Die AI Model Hub-Node bietet rund 20 Operationen für vier Ressourcentypen:

Modell-Inferenz

Dies ermöglicht das Senden von Prompts an jedes Modell im Hub für die Generierung von Texten. Unterstützt werden RAG-basierte Abfragen (Retrieval-Augmented Generation), die Kontext aus eigenen Dokumentensammlungen beziehen, sodass Antworten auf spezifischen Daten basieren und nicht nur auf dem ursprünglichem Training des Modells.

Wissensdatenbank-Verwaltung

Diese Funktion dient dem Erstellen von Vektordatenbank-Kollektionen sowie dem Hochladen und Verwalten von Dokumenten für semantische Suchanfragen. Dies bildet die Grundlage für KI-Workflows mit tiefem Geschäftskontext – von Produktkatalogen über Richtlinien bis hin zu technischen Handbüchern.

OpenAI-kompatible API

Dieser Bereich stößt auf besonders große Resonanz. Die Operationen spiegeln die OpenAI-API exakt wider: Chat-Vervollständigungen, Text-Vervollständigungen, Embeddings, Bildgenerierung und Modell-Auflistungen. Bei einer bestehenden Nutzung von OpenAI in n8n-Workflows gelingt der Umstieg auf eine souveräne Infrastruktur durch den einfachen Austausch des API-Schlüssels. Der API-Vertrag bleibt identisch, ergänzt um die europäische Datenresidenz.

Für Teams, die bereits in OpenAI-basierte Workflows investiert haben, ist dies ein Migrationspfad, der eigentlich gar keine Migration erfordert. Keine Code-Änderungen, kein Neudesign der Workflows – lediglich ein anderer Zugang zu europäischer Infrastruktur.

Warum dies für europäische Unternehmen wichtig ist

Wir sind lange genug im europäischen Cloud-Markt tätig, um zu wissen, dass „Souveränität“ schnell zu einem leeren Schlagwort werden kann. Ein Blick auf die konkreten Änderungen für die Anwendenden verdeutlicht jedoch den tatsächlichen Nutzen dieser Integration.

Das Compliance-Problem ist real

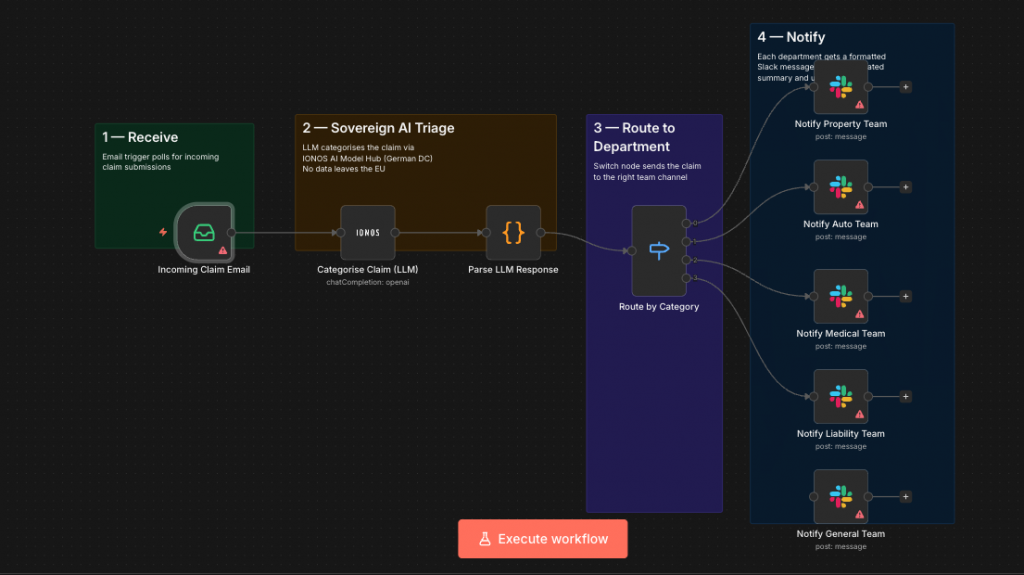

Ein mittelständisches Versicherungsunternehmen in Frankfurt möchte KI nutzen, um eingehende Schadensmeldungen zu triagieren. Ein LLM soll die Beschreibungen lesen, kategorisieren und an die richtige Abteilung weiterleiten. Technisch ist das trivial. Doch in dem Moment, in dem Kundendaten einen nicht-europäischen Modellanbieter erreichen, stellt der Datenschutzbeauftragte kritische Fragen – zur Datenresidenz, zum Zugriff durch Drittstaaten und zur Belastbarkeit der Auftragsverarbeitungsverträge.

Mit unserer n8n-Integration sieht dieser Workflow entscheidend anders aus: Ein E-Mail-Trigger empfängt den Schaden, die AI Model Hub-Node sendet ihn an ein Open-Source-LLM in einem deutschen Rechenzentrum, und das Ergebnis wird über eine IF-Node direkt an den entsprechenden Team-Kanal in Slack oder Teams geleitet. Der Datenschutzbeauftragte kann nun auf eine Infrastruktur verweisen, die vollständig innerhalb der eigenen Jurisdiktion liegt und von einem europäischen Unternehmen betrieben wird, ohne dass Daten für ein Modelltraining verwendet werden. Das Gespräch verlagert sich schlagartig von „Dürfen wir das überhaupt?“ zu „Wie schnell können wir starten?“.

Die Lücke in der Handhabung für Entwickler war ein Hindernis

Vor diesem Paket musste die Verbindung von n8n mit der IONOS Cloud für jeden API-Endpunkt eigene HTTP-Request-Nodes manuell konfiguriert werden. Authentifizierung, Paginierung, das Parsen von Antworten und die asynchrone Bereitstellung mussten manuell verwaltet werden. Für einen Proof of Concept ist das in Ordnung, für produktive Workflows, die skalierbar und wartbar sein müssen, jedoch nicht.

Unsere Nodes übernehmen all das automatisch. Nach der Auswahl einer Ressource und einer Operation sowie dem Ausfüllen der Parameter erledigt die Node den Rest im Hintergrund. Ein einziger API-Schlüssel, der einmalig in der n8n-Benutzerverwaltung hinterlegt wird, funktioniert über alle fünf Nodes hinweg.

Open Source ist unverzichtbar

Wir haben uns bewusst für eine Open-Source-Veröffentlichung entschieden. Partnerunternehmen können das Paket forken, erweitern oder in eigene Produkte einbetten. Anwender können jede Zeile Quellcode prüfen, die ihre Infrastruktur berührt und die Community kann eigene Beiträge leisten.

Diese Entscheidung entspricht unserem Verständnis von Cloud-Infrastruktur. Bei IONOS haben wir die Initiative „Sovereign European Cloud API“ (SECA) mitbegründet, weil wir davon überzeugt sind, dass offene Standards und Interoperabilität die Voraussetzungen für echte Souveränität sind. Man kann keine souveräne Alternative anbieten, wenn man Kundinnen und Kunden gleichzeitig in proprietäre Tools einsperrt (Stichwort: Vendor Lock-in). Das gleiche Prinzip gilt hier: Wenn Automatisierungswerkzeuge die Infrastruktur verwalten, sollten Sie volle Transparenz darüber haben, was diese im Detail tun.

Ein Praxisbeispiel: Client-Onboarding für einen Managed Service Provider

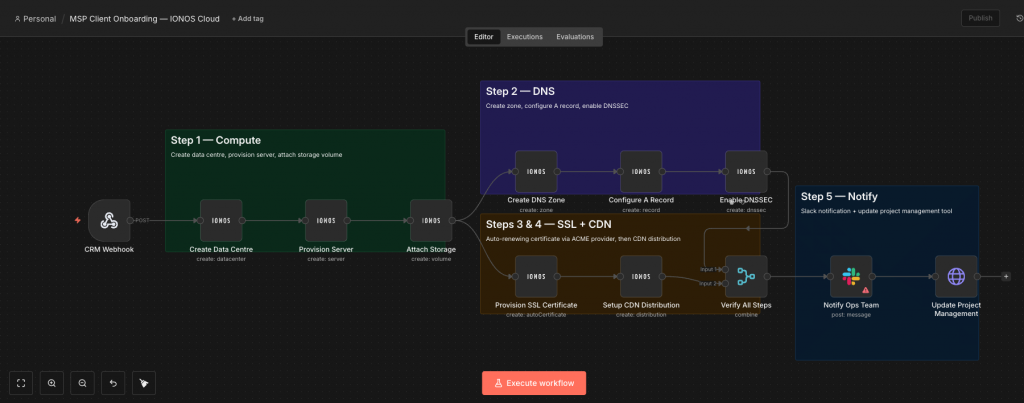

Das Versicherungsbeispiel zeigt die KI-Seite. Doch die meisten unserer Nodes betreffen die Infrastruktur und genau dort entfaltet die Zeitersparnis ihre volle Wirkung. Ein Workflow-Muster, das auf besonders großes Interesse stößt, ist das automatisierte Onboarding:

Ein Managed Service Provider (MSP) nimmt regelmäßig neue Kunden an Bord. Jeder Kunde benötigt eine dedizierte Cloud-Umgebung: Server, DNS, SSL-Zertifikate und ein CDN für statische Inhalte. Bisher bedeutete dies Stunden manueller Arbeit in verschiedenen Dashboards. Mit unseren n8n-Nodes läuft die gesamte Sequenz nahtlos in einem einzigen Workflow ab:

- Schritt 1 – Compute: Ein CRM-Webhook löst aus, sobald ein Vertrag unterzeichnet ist. Die Infrastructure-Node erstellt ein Rechenzentrum, stellt Server mit den gewünschten Spezifikationen bereit, bindet Speicher-Volumes ein und konfiguriert das Netzwerk.

- Schritt 2 – DNS: Die Cloud-DNS-Node richtet die Domain-Zone des Kunden ein und konfiguriert A-Records, die auf die neuen Server zeigen. DNSSEC wird automatisch aktiviert.

- Schritt 3 – SSL: Die Certificate Manager-Node stellt ein sich automatisch verlängerndes Zertifikat über Let’s Encrypt bereit. Keine manuelle Verlängerung, keine Terminerinnerungen.

- Schritt 4 – CDN: Die CDN-Node erstellt eine Distribution für die statischen Inhalte des Kunden mit den passenden Routing-Regeln und Geo-Restrictions.

- Schritt 5 – Benachrichtigung: Eine Slack-Nachricht mit der Bereitstellungsübersicht geht an das Ops-Team, und das Projektmanagement-Tool wird automatisch aktualisiert.

Server, DNS, SSL, CDN – automatisch bereitgestellt und verbunden in Minuten statt Stunden. Der Workflow bleibt für das gesamte Team einsehbar und pflegbar, anstatt in einem komplexen Skript ohne allgemeines Verständnis verborgen zu bleiben.

Wie es weitergeht

Das ist erst der Anfang, denn wir entwickeln das Paket aktiv weiter. Da unser Engineering-Team das Paket direkt betreut, erscheinen Updates zeitgleich mit neuen API-Funktionen unserer Cloud. Es gibt keine Wartezeiten durch Release-Zyklen von Drittanbietern.

Darüber hinaus setzen wir auf den direkten Dialog. Das Schöne an Open Source ist, dass die Roadmap gemeinsam gestaltet wird. Falls Bedarf an zusätzlichen Operationen, einer verbesserten Fehlerbehandlung für spezielle Anwendungsfälle oder neuen Integrationsmustern besteht, lassen sich diese ganz einfach als Issue auf GitHub melden oder direkt als Pull-Request einreichen.

Technische Ressourcen:

Mehr als 200 Operationen. Fünf Nodes. Open Source. Souveräne europäische KI inklusive. Das ist die Kurzfassung. Die ausführliche Version spiegelt unsere Überzeugung wider, dass Automatisierungstools genauso offen und transparent sein sollten wie die Infrastruktur, die sie verwalten. Europäische Unternehmen sollten nicht zwischen leistungsstarker Automatisierung und Datensouveränität wählen müssen. Mit dieser Veröffentlichung gehört dieser Kompromiss der Vergangenheit an.

Installation und Einstieg

Als offiziell verifizierter Community Node ist das Paket direkt im n8n-Interface sichtbar — mit geprüftem Code, garantierter Kompatibilität bei neuen n8n-Versionen und Ein-Klick-Installation. Einfach unter Einstellungen → Community Nodes → Installieren den Paketnamen @ionos-cloud/n8n-nodes-ionos-cloud eingeben — fertig in unter einer Minute. Erforderlich ist lediglich ein IONOS Cloud API-Schlüssel.

Sollten Sie noch keine n8n-Instanz haben, haben Sie die Wahl:

- Der schnellste Einstieg: Unser spezielles VPS mit vorinstalliertem n8n

- Maximale Flexibilität: Die Bereitstellung auf der IONOS Cloud Compute Engine für die volle Kontrolle über Ihre Umgebung

- Ohne Selbsthosting: Direkte Installation in n8n Cloud — ebenfalls mit nur einem Klick

In allen Fällen laufen Automatisierungsplattform und Cloud-Infrastruktur nahtlos unter einem Dach.